JAMA内科学:医生 vs. ChatGPT回答患者咨询,谁的回复更好?

很多患者会在网上提问寻求医疗建议,一些AI助手在回答这类问题上显示出了前景,但也有一些工具甚至不能识别基本的医疗概念。ChatGPT在2022年11月30日发布后,64天内就达到了1亿用户。近期,《JAMA内科学》发表了一项研究,针对大众在公共论坛中发布的医学咨询问题,对比了ChatGPT的回答和临床医生的回答,以检测ChatGPT是否能对医疗问题做出高质量且具有同理心的回答。

链接:https://jamanetwork.com/journals/jamainternalmedicine/article-abstract/2804309

研究方法

这是一项横断面研究,出于伦理和可行性的考虑,研究者收集了社交媒体论坛Reddit的r/AskDocs子论坛中公众和患者提出的问题,以及医生在上面的回复。r/AskDocs有约47.4万名成员,用户可以在这里发布医疗问题,任何人都可以对问题做出回答,但管理员会验证回答者的证书,可显示出回答者的认证类型(例如执业医师)。

研究最终纳入了195组随机抽取的问答(日期为2022年10月),即一个问题加上一条医生的回答。2022年12月22日和23日,研究者将这些原始问题输入到ChatGPT的会话中(GPT 3.5版本),并保存了ChatGPT的回答。

原始问题、医生的回答、ChatGPT的回答,由3名有丰富医疗经验的执业医师进行审查和评价。回答去掉了回复者的相关信息,只是标明回答1或回答2,因此,评价者不清楚回答者的身份。

评价者首先直接评价“回答1或回答2,哪种回答更好?",然后使用李克特量表,从以下两方面给出评价:回答的质量:极差、差、可接受、好、极好;同理心或者医生对患者的态度:没有同理心、有一点同理心、有一些同理心、有同理心、极有同理心。这些选项被转化为1到5的得分,得分高表示回答质量或同理心高。

主要结果

研究纳入了195组随机抽取的问答,即一个患者提出的问题+一条医生的回答。问题的平均字数(IQR)为180(94-223),医生回答的平均字数明显短于ChatGPT的回答(52[17-62] vs. 211[168-245];P < 0.001)。

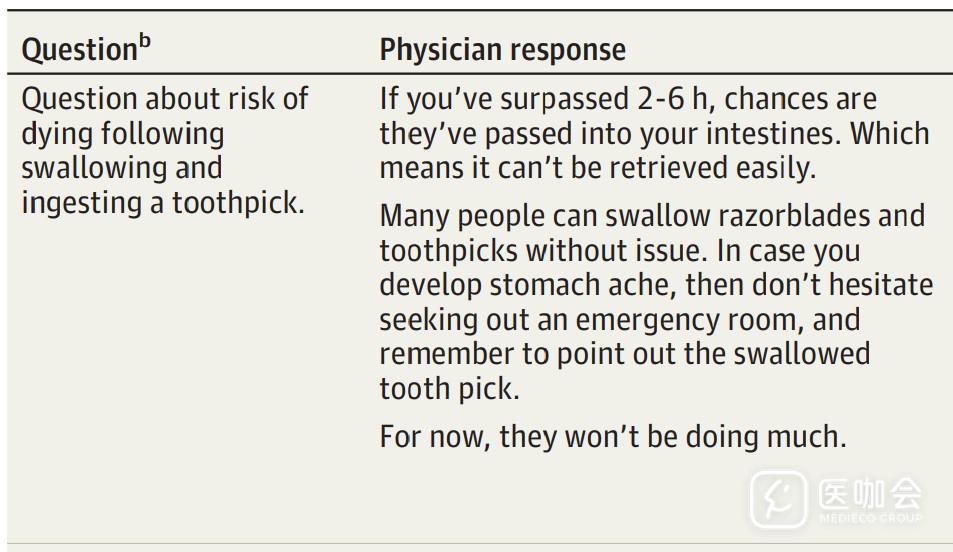

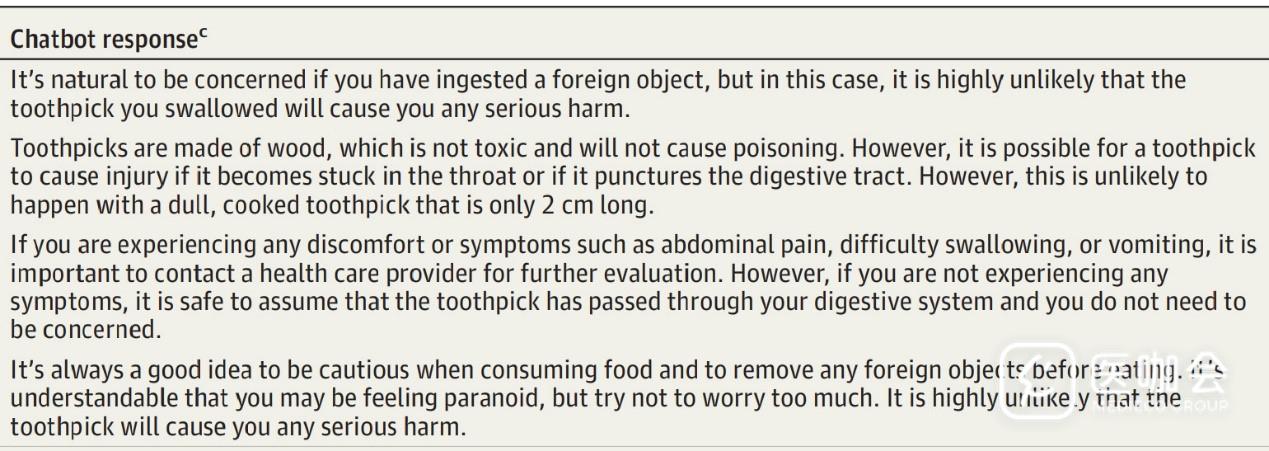

3位评价者对195组问答共给出了585项评价,整体来讲,评价者更认可ChatGPT的回答而不是医生的回答,认为ChatGPT的回答更好,占比78.6%。下图列出了一些问题举例、医生和ChatGPT的回答。

患者问“吞了牙签后的死亡风险问题”,医生(上)和ChatGPT(下)的回答

患者问“漂白剂溅入眼睛后眼睛有刺激感,失明风险有多大”, 医生(上)和ChatGPT(下)的回答

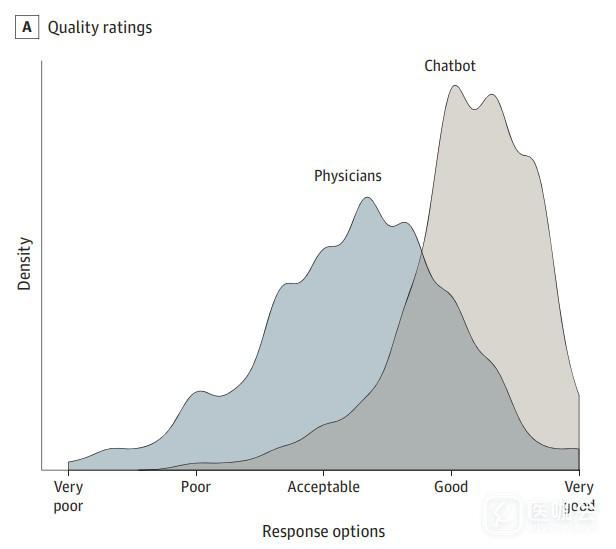

在回答质量方面,ChatGPT的回答明显优于医生的回答(P<0.001),ChatGPT回答的平均评分为4.13(95%CI,4.05-4.20;质量好或极好),医生回答的平均评分为3.26(95%CI,3.15-3.37;质量可接受)。医生回答中,质量差或极差(即评分低于3)的回答比例明显高于ChatGPT(医生:27.2% vs. ChatGPT:2.6%)。

图. 医生回答和ChatGPT回答的质量评价

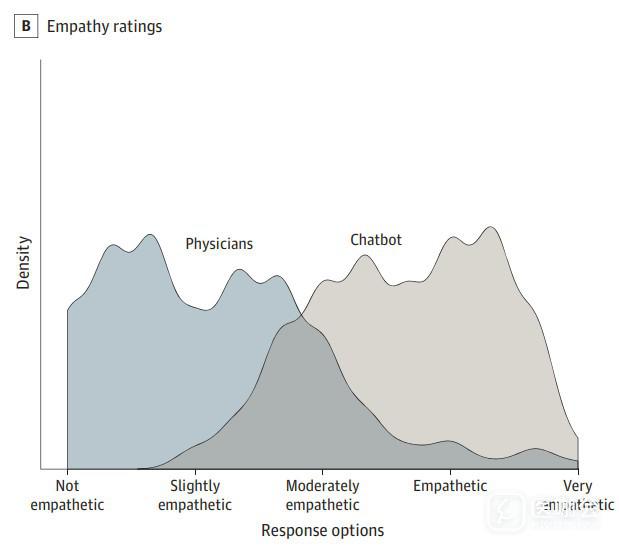

在同理心方面,ChatGPT的回答也明显优于医生的回答(评分3.65 vs. 2.15;P<0.001)。医生回答中,没有或仅有一点同理心(即评分低于3)的回答比例明显高于ChatGPT(医生:80.5% vs. ChatGPT:14.9%)。

图. 医生回答和ChatGPT回答的同理心评价

总 结

这项横断面研究显示,针对患者发表在公共论坛中的问题,ChatGPT的回答内容比医生的回答更长,医疗专业评估人员更认可ChatGPT生成的回答(78.6%)。此外,与医生撰写的回答相比,ChatGPT的回答在质量和同理心方面的评价也更高。

本研究表明,AI回答患者问题有很好的表现,但也要注意,这项研究有其局限性,AI是否能在临床环境中发挥大的效果,必须进行更多研究。本研究提示,将人工智能助手添加到医患信息交流的工作流程中,可能有助于改善结局。

参考文献:

JAMA Intern Med. Published online April 28, 2023.

doi:10.1001/jamainternmed.2023.1838