今天一早,就收到了老同学的信息,说她的一篇SCI论文刚刚发表,就收到了来自于“Academic Language Integrity Group (学术语言规范组, ALIG)”的来信,质疑其题为“XXX”的论文15%的内容由ChatGPT等大型语言模型(LLM)生成,可能涉及学术不端。

在这封来自于“ALIG< noreply@aligacademic.org >”为发信人的邮件中,ALIG同时给出了链接,可以通过其网站进行“验证”。

我仔细研读了这封来信,发现:

1)ALIG已经明确将由ChatGPT等LLM生成的论文认定为学术不端;

2)ALIG按照其查到的论文中使用LLM的比例分为5大类。

具体来说,这五类如下:

- 微乎其微的LLM使用(LLM内容<5%):在这一类别中的论文在数据库中自动获得验证状态。

- 轻度LLM使用(LLM内容5-20%):这一范围内的论文可能会被误认定,因此会被给予利益的质疑。在可能由于过度正式或非母语英语写作风格引发的误报情况下,ALIG提供语言验证服务。该服务进行双盲同行评审,以确定并合法验证手稿的人类作者身份,从而解决任何现存或潜在的争议。

- 中度LLM使用(LLM内容>20%):对于这一类别中的论文,其核心论点的有效性可能会受到质疑。在这种情况下,ALIG有权要求进行全面的同行评审过程,涉及领域特定专家来评估手稿的AI参与程度和可信度。

- 显著LLM使用(LLM内容30-50%):这一类别中的出版物可能会暂时撤回,等待作者澄清和重新评估LLM内容。

- 重度LLM使用(LLM内容>50%):这种情况会导致立即撤回。作者及其机构会被告知,事情会报告给美国高等教育部,可能会在AAA 2022规则下面临制裁。

说到这里,如果你是通讯作者,收到这封信会有什么反应?

我一边安慰同学,说你的论文只有15%涉嫌LLM撰写,不必理会这封信。

同时,我也登录到了ALIG网站进行了查询。

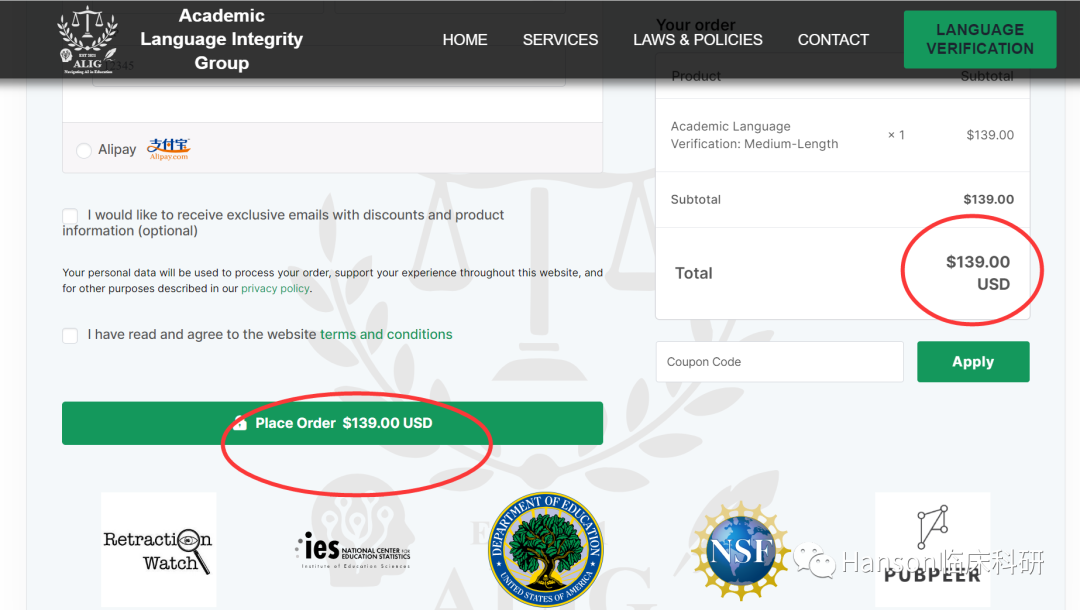

感觉有点怪,因为这是一个在线LLM使用“核查”网站;并且收费不菲,高达139美元!

我问了ChatGPT关于ALIG的信息,ChatGPT坦言,没有任何这方面消息;

我又通过New Bing的chat对话框进行了查询,问ALIG是否是一个欺诈机构;同样没有得到准确的答复。

通过Google搜索,也没有ALIG在学术方面的任何信息。

编者按:

尽管我们目前没有证据显示ALIG的具体情况,但目前的初步结论是:

1)不要被ALIG的来信操纵,尤其不要付费去做所谓的验证;

2)目前对于ChatGPT等AI撰写的论文,尽管确实不能滥用以免潜在的“学术不端”指控,但实际上目前对于“AI撰写的论文是否涉嫌学术不端”尚未有统一的定论。

对于ChatGPT等LLM的使用,确实应该明确规定其在学术研究中的适用范围和条件,并尽可能提高其使用的透明度。所以在使用这些工具时,我们需要清楚其潜在的风险和责任。

但对于这类(不是通过期刊编辑部)直接给作者发邮件要求去他的网站上付费验证的情况,亦应该提高警惕其“网络欺诈”的可能。

转载自:Hanson临床科研,作者:Mark博士